《科创板日报》8月24日讯(记者 张洋洋)国产大模型企业DeepSeek“点燃”资本市场券商配资。

近日,DeepSeek宣布其新一代模型DeepSeek-V3.1采用了UE8M0 FP8 Scale参数精度,并明确指出该精度标准是针对即将发布的下一代国产芯片设计。这一消息迅速在资本市场引发强烈反应,寒武纪等芯片类上市企业股价集体拉升。

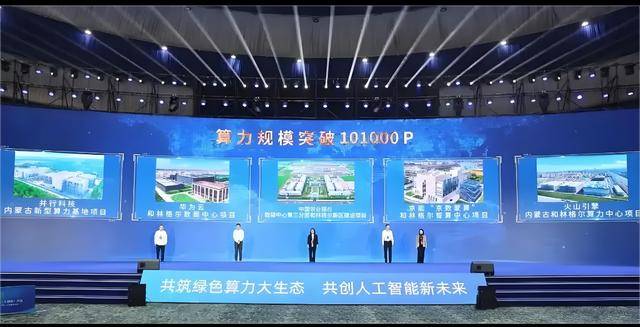

不过,在近两日举办的2025算力大会上,据《科创板日报》记者的现场采访和观察来看,大家在聚焦国产算力时,DeepSeek的FP8精度标准虽被讨论,但业内人士的情绪显然没有资本市场那么高亢。技术派更关注FP8在模型训练、推理及生态标准化上的实际价值与挑战。

▍FP8是什么,有哪些提升?

在AI训练与推理过程中,为提升计算效率,数值精度的降低是一个常见的技术路径。

摩尔线程AI Infra总监陈志向《科创板日报》记者称,过去,大模型训练推理普遍使用FP32(32位浮点数),随后逐步过渡到FP16(16位浮点数)混合精度,以减少存储和通信开销,FP8则进一步将数据宽度压缩至8位。

“FP8最直接的优势是算力效率翻倍,另一个好处是降低降低训练和推理过程中网络带宽的通信量。”陈志称,比如原本传输一个FP32数值需4字节,现在仅需FP8仅需要1字节,虽然网络物理带宽本身未必扩大,但单位时间内可传输信息是增加的,同时也让存储要求降低。这意味着在相同功耗下,AI芯片可训练更大的模型或缩短训练时间。

不过,FP8也不是万能的。

在2025算力大会现场,另一名不愿具名的国产芯片厂商从业人员告诉《科创板日报》记者,用类似FP8低精度训练推理虽然快,但也容易因数值范围太小导致计算出错。而且券商配资,不同计算对精度要求不同,像矩阵乘法这类操作对精度不敏感,可以用较低的精度(如FP8)计算;而像累加或某些函数则需要较高精度。因此,业内通常采用“混合精度训练”,根据计算类型动态选择不同的精度,兼顾效率与准确。

联华证券提示:文章来自网络,不代表本站观点。